摘录§

学习如何消除数据冗余,提高存储、性能和准确性。发现诸如规范化、数据去重、集中化、验证、核实和定期审核等策略,以防止数据系统中的错误、不一致和混淆。

数据冗余 是指在多个位置存储重复或重叠数据。这是一种不良结果,可能以各种方式对系统产生负面影响。通过应用规范化、去重和集中化等技术,组织可以有效地识别和消除冗余数据。

理解数据冗余§

数据冗余是指相同的数据在不同位置(如数据库、电子表格和其他存储库)中的复制。一些常见的原因包括:

- 包含重叠信息的多个数据源

- 在迁移或集成过程中记录的重复

- 在规范化不良的数据库中存在重复组和属性

- 在没有清理的情况下在系统之间复制数据

冗余增加了存储和维护成本。当重复数据更新时,它还会增加数据不一致性、错误和异常的风险。消除冗余对于优化存储、性能和准确性至关重要。

识别数据冗余§

数据冗余的典型症状包括:

- 表示相同实体或事件的多个记录

- 表中的重复组或列

- 存储在不同系统中的相同数据元素

- 重复或过时数据的数量

仔细分析模式、查询、报告和统计分布有助于发现冗余。数据分析工具可以自动标记重复和冗余问题以供调查。

数据冗余的影响§

数据冗余会带来多个数据质量挑战:

- 增加的存储 - 需要额外容量来维护冗余数据

- 不一致性 - 更新可能导致重复数据随时间发生变化

- 错误 - 冗余的过时数据可能传播不准确性

- 混乱 - 在冗余中不清楚哪个来源是权威的

- 更难维护 - 任何更改都需要更新多个系统

这些影响可能会降低对数据的信心并扭曲分析结果。

消除数据冗余的策略§

以下是消除冗余的 5 个关键方法:

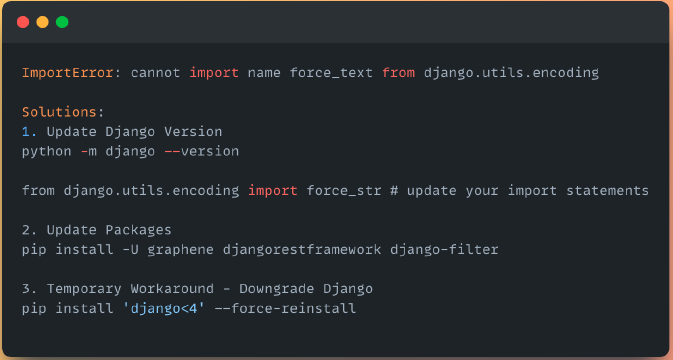

1. 规范化§

将表重组为高效的规范形式可以消除重复组和属性。这通过原子、非冗余记录来最小化重复。

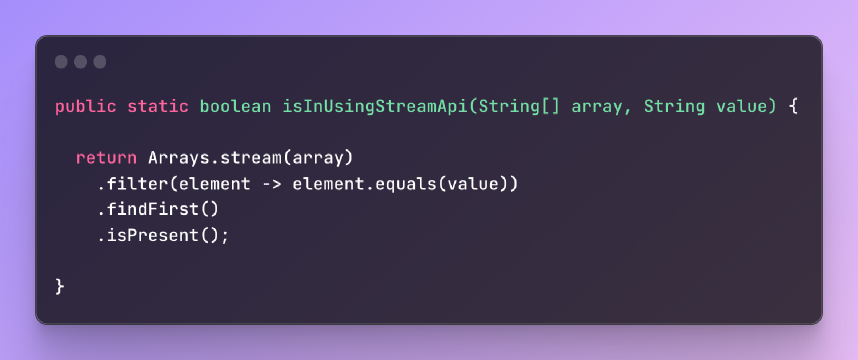

2. 数据去重§

将重复记录识别并合并为权威的主记录可以提高数据质量和一致性。

3. 数据集中化§

将数据合并到较少的权威系统中可以减少分散和冗余。主数据管理有助于集中域。

4. 数据验证和验证§

输入验证和完整性检查有助于防止错误的重复数据进入系统。输入后验证可以识别现有的冗余。

5. 定期数据审计§

通过审计和分析进行周期性冗余分析,确保通过持续的数据监督来控制冗余。

防止数据冗余的最佳实践§

- 制定关于防止冗余的数据管理政策

- 开发清晰的数据模型和优化的模式

- 将质量检查整合到 ETL 过程中,以避免重复

- 将多个系统合并到集中存储库中

- 安排定期数据审计和去重倡议

- 使用持久唯一标识符记录

结论§

数据冗余对质量、存储和维护产生不利影响。结合规范化、去重、集中化和治理的多方策略是控制冗余的关键。通过仔细的分析和计划,组织可以优化数据架构,消除低效的重复,并提高整体数据真实性和可靠性。